Effiziente Datenverarbeitung in den angewandten Geisteswissenschaften

von Wolfgang Näser, Marburg, August 2012 ff.

Wir schreiben das Jahr 2012. Nicht weniger als

31 Jahre sind vergangen, seit der erste richtige IBM-PC (dessen

"Rechenwerk" heute in einem Stück Würfelzucker Platz fände)

seine Markt-Premiere erlebte: mit nur 64 kB RAM und einem bescheidenen

180-kB-Laufwerk. Sozusagen eine Art elektronischer (oder eher noch: elektrischer)

Speicher-Schreibmaschine. Erst zwei Jahre später gab es einen erweiterten

Speicher: die erste 10-Megabyte-Festplatte. Das Internet existierte

bereits im Experimentierstadium, doch an ein World Wide Web war

ebensowenig zu denken wie an Soziale und andere Netzwerke,

geschweige denn an echte Multimedia-Arbeit mit einem Personal Computer.

Lange Zeit wurde die komplette PC-Arbeit mit

DOS-Programmen und -Befehlen geleistet.

Heute dagegen sitzt der private oder berufliche Anwender beispielsweise an

einem kleinen Rechner, den er überallhin mitnehmen kann, dem

11-Zoll-Netbook mit 6 Gigabytes RAM und einer Festplatte von

320 GB, er orientiert sich an meist intuitiv verstehbaren, per

Maus oder Touchpad anklickbaren Programm-Fenstern,

kommuniziert drahtlos mit dem World Wide Web, loggt sich

in Soziale Netzwerke ein, empfängt riesige Datenmengen im

Gigabyte-Umfang von hunderttausenden internationalen Servern, er

verarbeitet multimediale Daten*), lädt Video-Clips in einen weltweit

empfangbaren Server namens YouTube. Das bescheiden anmutende sogenannte

Packard-Bell Easy Note NCL 20 hat nicht einmal 400 Euro gekostet und

besitzt auch ein integriertes Laufwerk, mit dem sich CDs und

DVDs lesen und "brennen" lassen. Der kontrastreiche Bildschirm hat

eine hohe Auflösung, die dargestellten Schriften lassen sich beliebig

skalieren und die geschriebenen und je nach Zweck formatierten Texte mit

einem Tintenstrahl- oder Laserdrucker ausgeben. Alle externen

Geräte werden vom Betriebssystem automatisch erkannt und über

spezielle Treiber aktiviert.

*) nicht alle Multimedia-Spielarten lassen sich mit einem bescheidenen Netbook

verarbeiten; Zum Editieren von Filmen ist ein aufwendigerer Rechner nötig.

Damit habe ich, am Beginn meines Textes, den Ist-Stand vom Herbst 2012 skizziert

- der schon obsolet zu werden droht, ist doch die Zeitstrecke der IT-Entwicklung

gespickt mit nahezu monatlich bekannt werdenden Innovationen; wir leben in

einer totalen Informationsgesellschaft, wo in Sekunden alles Wissenswerte

in einer Datenbank namens Wikipedia nachgeschlagen wird, die in weit

mehr als 100 Sprachen verfügbar ist und an der tausende freiwillig und

unentgeltlich mitarbeiten - an der größten und aktuellsten

Enzyklopädie unserer Zeit. Unzählige kommerzielle Daten-DVDs

enthalten so nützliche Sammlungen wie zum Beispiel rund 34 Millionen

deutsche Telefonanschlüsse, inclusive

Rückwärtssuche. Und es gibt, seit einigen Jahren, auch

sogenannte e-Reader, flach und etwa so groß wie ein

Frühstücksbrett und mit einem internen Speicher von 3 Gigabytes

oder mehr, auf deren weißem Bildschirm mittels der sogenannten

e-Ink-Technologie sogar bei hellem Sonnenlicht Bücher und Manuskripte

gelesen werden - tausende passen auf den internen Speicher.

Somit müßten wir alle glücklich sein. Ein wahres Paradies

an Informationsverarbeitung und Kreativität; noch undenkbar vor einem

halben Jahrhundert, auch wenn es schon damals riesige "Elektronengehirne"

gab, die ganze Säle füllten in den Rechenzentren der öffentlichen

Verwaltungen , der militärischen Organisationen und Universitäten.

Aber es war sonst noch alles analog. Analog wurde gefilmt, fotografiert,

wurden Ton und Bild aufgenommen, und Texte wurden mit schweren, teils

unhandlichen und langsamen Schreibmaschinen getippt - der

IBM-Kugelkopf war damals ein großer Durchbruch, die Typenhebel

verhedderten sich nicht mehr, es gab ja keine, und diese

Kugelkopf-Schreibmaschinen wurden deshalb zu "Terminals" in vielen Rechenzentren,

wenn es darum ging, einfache Texte so schnell wie möglich auszudrucken.

Mein Text ist nichts anderes als Reflexion, in Kurzform quasi das Produkt

von Erfahrungen aus mittlerweile 25 Jahren Arbeit mit verschiedensten

digitalen Rechnern, Aufnahmegeräten und anderem auf dem Gebiet der

Dokumentation und Informationsverarbeitung und soll das ergänzen, was

ich bereits an anderer Stelle in

meiner Homepage zu diesen Themen geschrieben habe. Ein kurzes Innehalten

der Besinnung auf das, was wesentlich ist und worüber man oft hinwegsieht

in der gnadenlosen Hektik unserer Zeit, deren Arbeitstakt sich dem Takt der

in immer kürzeren Abständen neu entwickelten Prozessoren anzupassen

scheint.

Meine Ausführungen gelten vornehmlich solchen geisteswissenschaftlichen

Bereichen, die sich in einer empirischen Forschung befassen mit

Datengewinnung (data retrieval), Datenauswertung- und

bearbeitung (Evaluation und Re-Editing) und Archivierung, also

mit Verfahren zur Informationsgewinnung und Dokumentation wertvoller

Phänomene und auch Aussagen, die vielfältig und von einem

möglichst großen Interessentenkreis genutzt und langfristig auch

für nachfolgende Generationen gespeichert werden sollten. Als Beispiel

für solches Arbeiten betrachte ich die Verfahrensweise der

angewandten Sprachwissenschaft auf den Gebieten der

Soziolinguistik, der sprachlichen Statistik, der Dialektologie und der Phonetik.

Mühsam und sehr aufwendig war die apparative Feldforschung in

ihren Anfängen. Um, wie beispielsweise im 1977 erschienenen

Arbeitsbericht der Marburger Phonetik gefordert, "archivfähige"

Sprachaufnahmen zu erzielen, waren damals professionelle Tonbandgeräte

nötig wie etwa im Außendienst die Nagra IV, die

damals noch (ohne Zubehör) rund 12.000 DM kostete, unübersehbar

klobige Mikrofone wurden aufgestellt, neben dem wissenschaftlich qualifizierten

Interviewer (Explorator) agierte ein mit Kopfhöreren bewaffneter

Toningenieur; im schalldichten Aufnahme-Studio wurden

Kondensator-Mikrofone von Georg Neumann benutzt und die Signale im separaten

Technik-Raum einem mit sogenannten Kassettenverstärkern bestückten,

rundfunktauglichen Mischpult zugeführt. Die hier auf "Maschinen" wie

dem Telefunken M 10 oder M 15 mit 38

cm/sec. und Vollspur gefertigten

Tonbänder wurden in großen Schränken und exakt klimatisierten

Räumen gelagert, was trotzdem gewisse Langzeitschäden wie

Schichtverklebung (bzw. -Ablösung) und / oder

unerwünschte Echos nicht ausschloß. Semiprofessionell

verwendete man im Außendienst das Uher Report oder das bei 19

cm/s rundfunktaugliche Grundig TK 3200 HiFi. Im

Cassettenrecorder-Bereich brillierte das auch im

Rundfunk-Außendienst verwendete Sony TCD-5M (links), das mit

guten Chromdioxyd- und vor allem mit Reineisenbandcassetten locker die HiFi-Norm

erfüllt. Bei mir arbeitet mein erstes TCD5M nun seit gut 27 Jahren ohne

Probleme und eignet sich noch heute ausgezeichnet als Analog-Recorder für

hochwertige Live-Konzertaufnahmen und / oder für explorative

Sprachdokumentation. Leider gibt es im Handel keine hochwertigen

Audio-Kompaktcassetten mehr.

cm/sec. und Vollspur gefertigten

Tonbänder wurden in großen Schränken und exakt klimatisierten

Räumen gelagert, was trotzdem gewisse Langzeitschäden wie

Schichtverklebung (bzw. -Ablösung) und / oder

unerwünschte Echos nicht ausschloß. Semiprofessionell

verwendete man im Außendienst das Uher Report oder das bei 19

cm/s rundfunktaugliche Grundig TK 3200 HiFi. Im

Cassettenrecorder-Bereich brillierte das auch im

Rundfunk-Außendienst verwendete Sony TCD-5M (links), das mit

guten Chromdioxyd- und vor allem mit Reineisenbandcassetten locker die HiFi-Norm

erfüllt. Bei mir arbeitet mein erstes TCD5M nun seit gut 27 Jahren ohne

Probleme und eignet sich noch heute ausgezeichnet als Analog-Recorder für

hochwertige Live-Konzertaufnahmen und / oder für explorative

Sprachdokumentation. Leider gibt es im Handel keine hochwertigen

Audio-Kompaktcassetten mehr.

Cassettenrecorder eignen sich übrigens noch immer bestens zur Auswertung

und vor allem zur Transkription von Texten. Die analog oder digital gefertigten

Tonaufnahmen sind hierfür auf einen robusten Recorder zu überspielen,

der eine verschleißfreie Cue- und Review-Möglichkeit besitzt,

mit der sich beliebig zwischen einzelnen Passagen hin und her navigieren

läßt. Der hier beschriebene

ITT SL 700 A war ein solches Gerät; wer es besitzt, kann sich

glücklich schätzen.

Es gab zwar bereits recht leistungsfähige Personal Computer, doch so

gut wie keine Möglichkeit, die gewonnenen auditiven und / oder visuellen

Daten dort weiterzuverarbeiten

Bereits an der Wende zur letzten Dekade des 20. Jahrhunderts zeichnete sich

ein bedeutender Wandel ab. Seit etwa 1987 gab es mit dem Sony TCD-D10

den ersten digital arbeitenden Recorder mit dem sogenannten

DAT-Verfahren, wobei sich das nur 3,81 mm breite, reineisenbeschichtete

Band analog der VHS-Videotechnologie um eine winzige Trommel schlingt und

dort im Schrägspur- oder Helikalverfahren bespielt wird. Die nur 7,2

x 5,3 cm messenden und rund 1 cm "dicken" DAT-Cassetten konnten in

CD-Qualität als "Audio"-Varianten 90 oder 120 Minuten speichern,

während die baugleichen sog. Streamer-Bänder bis zu 4 Stunden

Aufnahmezeit ermöglichten. Zum oftmaligen Abhören und

informationstechnischen Auswerten ließen sich die DAT-Bänder

natürlich fast verlustlos auf hochwertige Analog-Tonbänder oder

Kompaktcassetten speichern; sollte die Auswertung ebenfalls digital geschehen,

mußte als geeigneter Zwischenträger eine Selbstaufnahme-CD

dienen, die aber erst ab etwa 1996 zur Verfügung stand. War der

CD-Rohling entsprechend bespielt, so konnte sein Inhalt in den Computer

eingelesen ("gerippt") und dort entweder bearbeitet (editiert, gemastert)

oder mit speziellen Analyse-Programmen (z.B. phonetisch) ausgewertet werden.

Das CD-Recorder-Verfahren ermöglichte nun auch, auf beliebigem Equipment

(also von der Tonwalze bis zum Studio-Recorder) entstandene analoge Tonaufnahmen

entsprechend zu digitalisieren und auszuwerten. Neben der Datensicherung

mit meist PC-internen Laufwerken entstanden als selbständige Einheiten

CD-Recorder zur Tonaufnahme entweder auf spezielle, audiokonforme

oder auf gewöhnliche 12- und 8-cm-Datenrohlinge, somit auch die

Möglichkeit, "Direktschnitte" per CD-Recorder vorzunehmen, allerdings

mit dem Nachteil, daß sich die Audio-Rohlinge nicht löschen und

neu bespielen lassen. Mangels Mikrofoneingang benötigen diese Geräte

einen Vorverstärker, der (sofern möglich) über Lichtleiter

oder analog über Line out / Line in angekoppelt wird. Optimal arbeitet

das Sony- TCD5M als "Vorverstärker", denn es enthält u.a. einen

der besten Limiter und ermöglicht neben der digitalen parallel

eine analoge Aufzeichnung.

Digital, das hieß von nun an (fast ausschließlich) verlustfrei

arbeiten, während beim analogen Kopieren stets leichte

Qualitätseinbußen eintraten. Man durfte - und das stellte sich

erst später (manchmal zu spät) heraus, nur nicht den Fehler machen,

eine DAT-Aufnahme öfter abzuspielen,. weil dadurch Band und Kopf leicht

verschlissen werden; ferner zeigte sich langzeitig, daß in der Anfangszeit

(um 1990) gefertigte DAT-Aufnahmen schon nach zehn oder zwanzig Jahren nur

mit teils sehr unangenehmen "Spratz"-Störungen abgespielt (und dadurch

Teile unlesbar) wurden; zudem können das gefürchtete Band-Knittern

und das Festbacken des Bandwickels auch hier auftreten.

Nun ist die ganze, sich erst spät als problematisch erwiesene

DAT-Technologie inzwischen so gut wie Geschichte. Als eleganter und fast

verschleißfrei erwies sich das Anfang 1993 eingeführte

Minidisc-Verfahren. Die in ein nur 7 x 6,8 cm großes "Jacket"

eingepaßte, 6,2 cm große Platte erlaubt mit 5-facher (verlustloser!)

Komprimierung (ATRAC 3) bis 80 Minuten Aufnahmen in CD-Qualität und

eignet sich hervorragend für wissenschaftliche Tonaufnahmen (Feldforschung),

zudem ist sie sehr preiswert sowie lösch- und vielfach neu aufnehmbar.

Leider verabschieden sich derzeit (2012) auch die Minidisc-Recorder; die

Medien werden in den Fachmärkten verramscht.

Bis hierhin wurde ausschließlich auf "bewegliche" Datenträger

aufgenommen - mit dem Nachteil des Verschleißes und - bei den Archiv-CDs

- der unsicheren Datenschicht-Lebensdauer. Ab ca. 2005 vollzog sich

der Übergang zum Festkörper-Datenspeicher (solid state storage

module). Der semiprofessionelle Marantz-PMD 660, mit dem ich ab Juli 2005

meine Live-Konzertaufnahmen machte,

speichert auf Compact-Flash-Karten der Typen I und II und ermöglicht

mit letzteren Aufnahmen bis 32 (oder sogar 64) Gigabyte, speichert also

beispielsweise auf einer 4-GB-Karte rund 8 Aufnahmestunden in bester

CD-Qualität. Hernach wird der Karteninhalt mit einem geeigneten

Lesegerät in den PC übertragen und kann dort editiert bzw. gemastert

werden. Das Einlesen geht naturgemäß viel schneller als das in

Echtzeit vorzunehmende

Digitalisieren analoger

Audioaufnahmen.

Die Aufnahme auf solche Speicherkarten bedeutet also einen beachtlichen

Fortschritt; kritisch ist allein die Datensicherheit. Ratsam ist,

die Daten nicht nur auf einen PC bzw. ein Laufwerk hin auszulesen,

sondern gleich mehrmals zu sichern und mindestens einen gesicherten

Datensatz auf "read only" zu setzen.

Es geht aber noch kleiner. Wir kommen

zu den Mini-Recordern, die - teils auf internen Speicher, teils auf

externe SD-Karten aufnehmen. So z.B. der nur 11,5 x 3,5 x 1,5cm messende

Olympus DS-40 (links)

Es geht aber noch kleiner. Wir kommen

zu den Mini-Recordern, die - teils auf internen Speicher, teils auf

externe SD-Karten aufnehmen. So z.B. der nur 11,5 x 3,5 x 1,5cm messende

Olympus DS-40 (links)  mit seinem abnehmbaren

Stereo-Kondensatormikrofon, der ausgezeichnete Sprachaufnahmen ermöglicht,

dann der vom gleichen Hersteller gefertigte, nur 11,3 x 4,5 x 1,1 cm messende

"Digital Voice Recorder" DM-3 (rechts), der sogar HiFi-gerechte Stereo-Aufnahmen

in CD-Qualität (als *.wav) liefert, dann der ebenfalls semiprofessionelle,

doch sogar von manchen Musiker-Ensembles zu Dokumentationszwecken verwandte,

11x 6 x 3,2cm große Zoom-H2, der mit seinen eingebauten Mikrofonen

sogar echtes 2- oder 4-Kanal-Surround realisiert , auf SD-Karten bis

8 GB oder mehr in vielen MP3-Raten und in *.wav aufnimmt und ausgezeichnete

Limiter und Aufnahme-Klangbearbeitungswerkzeuge "an Bord" hat. Was das kleine,

weniger als 200 Euro "teure" Gerät vermag, dürften meine Aufnahmen

des Brandenburgischen Konzerts Nr. 3 (8/2010) und

der

"Rigoletto"-Ouvertüre

(8/2012) im Orchestergraben der Bad Hersfelder Stiftsruine zeigen. Weitere

Verbesserungen im Field Recording bringt der neue

Zoom-H2n(ext),

dessen 5 (!) eingebaute Elektret-Mikrofone nun auch Stereo-MS

(Mitte-Seite) ermöglichen; die in diesem Modus erzielbare Qualität

dokumentieren zwei (bearbeitete) erste Live-Aufnahmen vom 26.1.2013 aus der

Stadthalle Korbach: Antonin Dvoráks

"Furiant

g-Moll" und Richard Strauss'

Cello-Romanze

F-Dur. Neu ist hier neben dem wesentlich reduzierten

Batterieverbrauch (2x AA Mignon 1,5 V Alkali-Mangan für max.20 h)!

auch der eingebaute Kontroll-Lautsprecher. Somit gestattet das Gerät

nicht nur professionelle Mikrofonierungen, sondern ersetzt in seiner

Universalität den kompletten schweren Aufnahmekoffer, mit dem sich die

Exploratoren der 50er Jahre abquälen mußten.

mit seinem abnehmbaren

Stereo-Kondensatormikrofon, der ausgezeichnete Sprachaufnahmen ermöglicht,

dann der vom gleichen Hersteller gefertigte, nur 11,3 x 4,5 x 1,1 cm messende

"Digital Voice Recorder" DM-3 (rechts), der sogar HiFi-gerechte Stereo-Aufnahmen

in CD-Qualität (als *.wav) liefert, dann der ebenfalls semiprofessionelle,

doch sogar von manchen Musiker-Ensembles zu Dokumentationszwecken verwandte,

11x 6 x 3,2cm große Zoom-H2, der mit seinen eingebauten Mikrofonen

sogar echtes 2- oder 4-Kanal-Surround realisiert , auf SD-Karten bis

8 GB oder mehr in vielen MP3-Raten und in *.wav aufnimmt und ausgezeichnete

Limiter und Aufnahme-Klangbearbeitungswerkzeuge "an Bord" hat. Was das kleine,

weniger als 200 Euro "teure" Gerät vermag, dürften meine Aufnahmen

des Brandenburgischen Konzerts Nr. 3 (8/2010) und

der

"Rigoletto"-Ouvertüre

(8/2012) im Orchestergraben der Bad Hersfelder Stiftsruine zeigen. Weitere

Verbesserungen im Field Recording bringt der neue

Zoom-H2n(ext),

dessen 5 (!) eingebaute Elektret-Mikrofone nun auch Stereo-MS

(Mitte-Seite) ermöglichen; die in diesem Modus erzielbare Qualität

dokumentieren zwei (bearbeitete) erste Live-Aufnahmen vom 26.1.2013 aus der

Stadthalle Korbach: Antonin Dvoráks

"Furiant

g-Moll" und Richard Strauss'

Cello-Romanze

F-Dur. Neu ist hier neben dem wesentlich reduzierten

Batterieverbrauch (2x AA Mignon 1,5 V Alkali-Mangan für max.20 h)!

auch der eingebaute Kontroll-Lautsprecher. Somit gestattet das Gerät

nicht nur professionelle Mikrofonierungen, sondern ersetzt in seiner

Universalität den kompletten schweren Aufnahmekoffer, mit dem sich die

Exploratoren der 50er Jahre abquälen mußten.

Diese ganze Miniaturisierung führte natürlich auch zum Umdenken

bei der Aufnahme-Strategie. Während die im Explorations-"Feld"

befragten Gewährspersonen oft eine Scheu vor den aufgestellten Apparaturen

(besonders dem meist klobigen Mikrofon) hatten, ist es nun möglich,

mit sogenannten "Originalkopf"-Mikrofonen (hochwertige Elektretsysteme, die

wie kleine In-Ohr-Kopfhörer getragen werden und

Quasi-Kunstkopf-Aufnahmen liefern), mit geräteinternen

(Elektret-)Mikros oder mit auf den Tisch gelegten, fast unsichtbaren

Grenzflächenmikrofonen aufzuzeichnen, jedesmal in wissenschaftlich

und archivalisch voll verwertbarer (CD-)Qualität.

Somit läßt sich heute die gesamte Tonaufnahme-Ausrüstung

eines Dialektologen in einem Handtäschchen unterbringen und vollziehen

sich alle Schritte der Signalverarbeitung auf einem vergleichsweise

winzigen Arbeitsplatz. Als Haupt-Werkzeug genügt ein simpler, nicht

einmal 400 Euro "teurer" PC, um die Tonaufnahme bis zur Archivierung zu be-

bzw. verarbeiten. Der Computer ersetzt ein zu analogen Zeiten riesiges Labor

mit sehr teuren, speziellen 19-Zoll-Einschüben in sogenannten "Racks".

Die eingelesenen Tonaufnahmen werden mit teils kostenlosen Programmen

abgehört oder editiert, das heißt es werden Stör- und andere

unerwünschte Geräusche herausgeschnitten und es wird die jeweilige

Aufnahme für eine optimale Archivierung vorbereitet, die dann so vonstatten

geht, daß die Tonaufnahme auf einen hochwertigen, goldbedampften CD-Rohling

"gebrannt" wird. Nicht zu vergessen, daß beim PC-internen Sound

Editing noch vieles andere geleistet werden kann, um z.B. die

Tonqualität und Intensität der Aufnahme zu steigern

oder um sie in komprimierter, doch nicht weniger hochwertigen Form als MP3s

in bestimmten Verzeichnissen zu sichern oder auf ebenfalls winzige "Player"

zu speichern, von wo aus sie mit hochwertigen Kopfhörern oder über

Stereo-Anlagen abgehört bzw. in Vorlesungen präsentiert werden

können.

Das Argument, apparative Feldforschung sei aufwendig und vor allem teuer,

zählt also nicht mehr (was man "schon" im Jahre 1985 mit einfachen

Geräten erreichen konnte, dürfte die von mir damals erstellte

Dokumentation zu den waldeckischen Mundarten

beweisen). Jeder, also auch der Studierende, kann sich heute an solchen

Forschungsarbeiten beteiligen, was den möglichen "Input" bei

größeren Vorhaben vervielfacht.

Was jedoch nach wie vor fehlt, ist eine automatische Transkription, das

heißt eine per Computertechnik geleistete automatische Verschriftlichung

von Sprach- und Dialektaufnahmen nicht nach vorgegebenen Mustersilben, sondern

seriell Laut für Laut und daher objektiv und

objektneutral. Auch wenn sicher nicht alle sogenannten Allophone (also

z.B. die verschiedenen /r/-Typen) erkannt werden, würde eine rein

zeichenorientierte Roh-Transkription bereits den Hauptanforderungen der

empirischen Sprachwissenschaft genügen und viele tausende von Arbeitsstunden

ersparen. Man hat es versäumt, in den letzten beiden Jahrzehnten, als

sich auch und gerade im PC-Sektor enorme Leistungssteigerungen abzeichneten,

innerhalb eines großen Forscher-Pools um apparative und programmtechnische

Verfahren und um Algorithmen einer Auto-Transkription zu bemühen und

zu ersten Formen zu gelangen, die mit den heutigen Ressourcen durchaus zu

bewältigen wären.

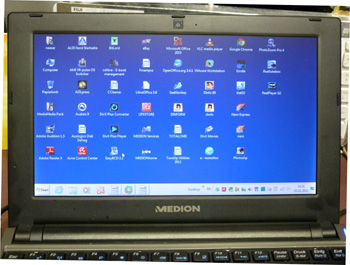

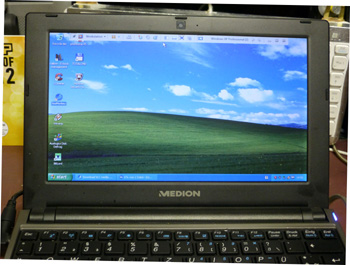

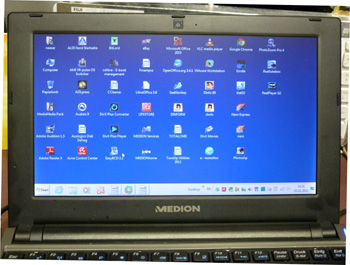

Ich habe oben von kleinen, handlichen, preiswerten Rechnern gesprochen, den

sogenannten Note- und Netbooks, aber noch nicht, was sie in

unserem Rahmen leisten und wie ihre Tauglichkeit zu prüfen wäre.

Auch kommt es nach meiner bisherigen Erfahrung darauf an, welches sogenannte

Betriebssystem und welche (erschwingliche) Software auf solchen

Rechnern läuft. Die einfachen, meist mit dem sog. Atom-Prozessor (1,6

GHz) oder, wie beim

Packard-Bell Easy Note Butterfly XS (kurz: NCL20)

mit dem Celeron (SU 2300, 1,3 GHz) bestückten kleinen Notebooks erreichen

natürlich nicht dieselbe Performance wie ein mit ultraschnellem Prozessor

und ebensolcher Grafik-Karte bestückter, voll Spiele-fähiger

Hochleistungs-PC oder das in puncto Bildschirm- und Tonausgabe noch immer

als "Rolls-Royce" unter den Notebooks bezeichenbare Mac Book Pro,

sind aber für unsere Zwecke völlig ausreichend. Meine

diesbezüglichen Erfahrungen basieren auf vielen hundert oder gar tausend

Arbeitstunden mit u.a. mehreren EeePCs, davon hauptsächlich mit

einem im März 2009 erworbenen Medion Akoya E 1212, den ich auf

2 GB RAM und eine Betriebsfestplatte von 1 TB hochgerüstet

habe, und dem kürzlich erworbenen, oben erwähnten Packard-Bell-

Rechner mit 64-Bit-Architektur und 6 (statt original 3) GB

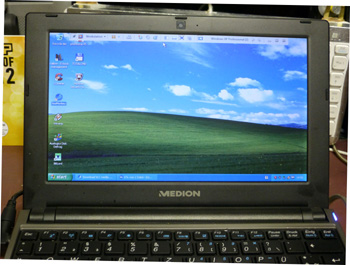

RAM. Auf der 1-TB-Platte des fast vier Jahre lang quasi im Dauereinsatz benutzten

Akoya 1212 habe ich drei verschiedene Betriebssysteme implementiert: (L)Ubuntu

/ LXDE (13.04), Windows XP (Home, SP 2) und Windows 8 (Consumer Preview).

Als neues Vergleichsgerät zu beiden Rechnern dient der zierliche Medion

Akoya E 1230 mit seinem neuen Prozessor (Intel Atom N2600, 2 Kerne,

1,6 GHz), mit 320 GB Festplatte, USB 3.0 und (unter Windows 7 Ultimate) max.

3 GB nutzbarem RAM (mit 4GB-Modul). Dieser kleine Rechner ermöglicht

einen gerade auch für schnelle Recherchen und den text- und

tonprobenorientierten Lehrbetrieb interessanten Modus operandi, nämlich

Medion Fast Boot.

Das ist eine ultraschnell startende, WLAN- und (je nach Hardware)

multimediafähige, reduzierte Variante des Linux-Derivats Ubuntu. Ich

installiere Fastboot im brandneuen Medion Akoya E 1230; hier läuft Ubuntu

12.04 lediglich in der 32-Bit-Version mit 800x600-Pixel-Grafik. Bislang

scheiterten verschiedene Versuche (Installation von Ubuntu 12.10,

Kernel-Upgrade auf 3.5, Einbindung des Cedar Trail drm driver in

DKMS format), hier 1024x600 Pixel zu aktivieren (auch das im Mai 2013

installierte neue Ubuntu 13.04 brachte keine Änderung). Auch unter

VMWare gab es keinen Erfolg: nach langem, hakeligem Lubuntu12.10-Setup

(von *.iso) gelang zwar eine Chromium-Browser-Session, doch hing der Computer

nach dem VMWare-Ausstieg und ließ sich nur per Kaltstart rebooten.

Der Rechner hat für Fastboot eine Option im (beim Booten mit

<F2> erreichbaren) Setup; in den auf D:\tools untergebrachten

Installations-Dateien befindet sich (möglicherweise aus *.exe oder *.zip

auszupacken) eine längere *.img-Datei, die als ion.img in

D:\VR-pulse\ zu kopieren ist. D:\ darf als Partition (Laufwerk) nicht

komprimiert sein.

Nach dem Neustart geht es mit <F9> zur Fastboot-Installation, die einige

Minuten dauert; dabei wird ein spezifisches Unterverzeichnis

\VR-pulse\vrpulse-data\ eingerichtet und darin als endgültiges,

hardwarebezogenes Fastboot-Betriebssystem opt.img generiert;

ferner werden 2 Subdirectories \Downloads und \email eingerichtet. Bald erscheint

in der Statuszeile rechts oben ein WLAN-Icon; von hier aus ist das

verfügbare WLAN anzuwählen und per Passwort einzurichten. Wenige

Sekunden später ist es bereit. Wir haben nun den unten abfotografierten

Bildschirm:

Sodann öffnen wir den Google-Chrom-Browser und bekommen folgende

Meldung:

Möchten Sie auf Google Chrome upgraden (zur Unterstützung von

Adobe Flash Player und PDF Reader)?

Anmerkung: Dies erfordert eine aktive Internet-Verbindung. |

Unbedingt <J(a)>; es werden von einem Server

http://archive.ubuntu.com/ubuntu/ natty/universe... (also dem Repository

von Ubuntu Natty Narwhale 11.04) die nötigen Dateien geholt,

um danach den Browser einzurichten. Dasselbe gilt für den

VLC-Player, auch für ihn sind (nach Ubuntu-Manier) weitere Dateien

zu holen. Thunderbird Mail hingegen bedarf nur noch der nutzerspezifischen

Konfiguration (mit Name, Mailadresse und Passwort), dann ist alles fertig

- zum sofortigen Arbeiten oder einem Restart.

Wir booten neu und sind mit <F9> nach wenigen Sekunden im

Fastboot-Betriebssystem, auch das WLAN hat sich eingeklinkt.

-

Vorausgesetzt, das Chrome-Upgrade (s.o.) wurde durchgeführt, können

wir nun beispielsweise in eine musikorientierte Website gehen und (mit einem

browserinternen Player) alle *.mp3 mit ausgezeichneter Qualität

anhören.

-

Mit dem Datei-Browser werden nur die Fastboot-Dateistruktur und die eingesetzten

externen Datenträger (SD-Karten, die meisten USB-Sticks, USB-gespeiste

Festplatten) angezeigt und eingelesen, während die mit Windows 7 verwalteten

Laufwerke/Dateisysteme "verschlossen" sind. Zugänglich ist die interne

Festplattenpartition D:\ nur für Fastboot-Downloads und

Thunderbird-Mail-Daten. Allerdings erlaubt der Dateimanager

Kopier-Operationen von und zu den von ihm verwalteten Dateistrukturen,

also z.B. (zu Sicherungszwecken) von einer auf SD-Karte generierten Datei

auch in das auf D:\ angelegte Directory \VR-pulse\vrpulse-data\Downloads\.

-

Extern gespeicherte *.mp3 werden mit dem VLC-Player wiedergegeben. Dieser

verarbeitet auch unter DVBT aufgenommene *.mpg ruckelfrei und mit guter

Tonqualität, streikt dagegen (in diesem Falle hardwarebedingt) bei

HD-Videos.

-

Entgegen dem ALDI-Werbefilm arbeitet der Fastboot-Bildschirm lediglich mit

800x600 Pixeln, was das Arbeiten mit dem Browser beeinträchtigt; noch

gibt es wohl keinen passenden Datensatz (*.img) für die neue

Cedarview-Grafik. Zudem befindet sich in der sonst ausführlich

gehaltenen Betriebsanleitung des E 1230 keinerlei Hinweis auf Fastboot und

dessen Installation.

-

Zum Fastboot-Deinstallieren ist lediglich der Inhalt von D:\VR-pulse\ zu

löschen.

Noch ein Wort zum Medion Akoya E1230: der kleine, schnelle Rechner

ist ein Musterbeispiel gut durchdachter Mikro-Architektur und Handhabbarkeit.

Einen unbeabsichtigten Fall aus ca. 70 cm Höhe (in vollem Betrieb)

überstanden Elektronik und Festplatte, nicht jedoch das

LCD-Display: es zeigte dasselbe Zerstörungs-Muster wie der

Hauptmonitor eines  portablen

Medion-DVD-Players MD82767 nach längerer Standzeit. Der Display-Rahmen

läßt sich mit einem scharfen Messer auseinanderteilen; die in

China von AU

Optronics hergestellte, ca. 50 Euro kostende Display-Einheit ("LCD-Matte")

B 101 AW06 V.0 hat ihren vielpoligen Micro-Connector an der

(weiß leuchtenden) Rückseite; das zu ihm hin führende vieladrige

Flachkabel ist am unteren Displayrand fixiert. Zum Austausch muß versucht

werden, die Display-Tafel schräg so aus dem Rahmen zu klappen, daß

das Flachkabel nicht beschädigt wird.

portablen

Medion-DVD-Players MD82767 nach längerer Standzeit. Der Display-Rahmen

läßt sich mit einem scharfen Messer auseinanderteilen; die in

China von AU

Optronics hergestellte, ca. 50 Euro kostende Display-Einheit ("LCD-Matte")

B 101 AW06 V.0 hat ihren vielpoligen Micro-Connector an der

(weiß leuchtenden) Rückseite; das zu ihm hin führende vieladrige

Flachkabel ist am unteren Displayrand fixiert. Zum Austausch muß versucht

werden, die Display-Tafel schräg so aus dem Rahmen zu klappen, daß

das Flachkabel nicht beschädigt wird.

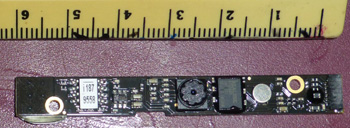

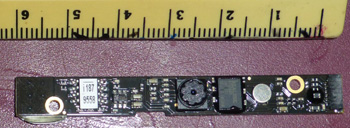

Rechts (Ableitung sw) und links Ableitung ws) des in SMD-Technik

gefertigten, via 6poliges Mini-Kabel versorgten audiovisuellen

WebCam-Moduls (Bild rechts) sitzen am oberen Bildschirmrand die

WLAN-Antennen PSAM 001. Falls das Display nicht ausgetauscht werden

soll, läßt sich dank seiner untadeligen Grafik das Netbook

natürlich über die VGA-Buchse an einem externen Monitor betreiben.

Weiteres zur praktischen Arbeit mit PCs

Hier fallen immer wieder bestimmte wichtige Prozesse an (und ergeben sich

Aspekte), auf die ich nun eingehe:

-

das Zeigen, Listen und Kopieren von Dateien sowie deren Re-Organisation

(Kopieren, Moven) in bestimmten Verzeichnissen und, letztlich, die "hygienische"

Neuordnung ganzer Festplatten bzw. Platten-Partitionen durch Defragmentieren,

alles zusammengefaßt im Begriff Datenverwaltung (data management).

Sofern mit mindestens 2 GB RAM ausgestattet, schaffen die Netbooks diese

Aufgaben problemlos, sofern nicht parallel andere Prozesse laufen. Als am

besten erwies sich (im Akoya E 1212) Windows XP, während Lubuntu

Probleme hatte mit komplexem Data Management. Das versuchsweise

implementierte Windows 8 zeigte keinerlei Vorteile.

Als allerbester Datei-Manager erwies sich der Windows Commander (jetzt

Total

Commander), der auch als kostenlose Shareware alle Features der

kommerziellen Version bereitstellt. Der TC arbeitet unter sämtlichen

Betriebssystemen, als Wine-Applikation sogar unter Ubuntu. Es gibt auf diesem

Sektor nichts Besseres. Selbst Archivdateien (*.zip, *.arj, *.sit usw.) lassen

sich verwalten, man kann in *.zips hineinsehen und Dateien darin editieren,

beliebig Dateien hin und her schieben usw., zudem bietet das Programm u.a.

einen sehr effektiven FTP-Client, der mit Up- und Download auch

und vor allem die Verwaltung eigener Homepages erleichtert.

Beim Defragmentieren zeigte sich das systemeigene dfrg von Windows

XP am effektivsten, während es unter Windows 7 (bzw. 8) nichts

Gleichwertiges gibt (das Tune-Up-Programm war nicht immer zuverlässig).

-

das Browsen (zwecks Informationsgewinnung) im World Wide Web.

1. Während sich in den kleinen 32-Bit-Rechnern der Microsoft

Internet Explorer 8 umständlich daherquälte, ging mit dem Mozilla

Firefox und dem Sea Monkey das Browsen flott vonstatten. Je komplexer

das Surfen, z.B. beim Scrollen umfangreicher Seiten (Chroniken) in

Facebook, zeigte sich Lubuntu den beiden Microsoft-Konkurrenten klar

überlegen, was auf eine bessere Speicher-Verwaltung

zurückzuführen ist. Informationsgeladene "Vielfenster"-Seiten wie

Facebook sind ohnehin ein hervorragendes Objekt zum vergleichsweisen Testen

von Rechner-Architekturen. Während (unter Win 8.1) der schon einige

Jahre alte Samsung RF-511 mit seinem i7-Prozessor und den 8 GM RAM

flüssiges Absurfen der Seite gestattet, hat (unter Win XP/Sp3) das ansonsten

recht komfortable, 2003 und 2004 gebaute IBM-"Thinkpad" R40 einige

Mühe, mit seinem auf max. 1,9 GHz (!) getakteten P4-Prozessor und immerhin

schon bis 2 GB RAM die komplexe Seite abzuscrollen, wobei die CPU fast durchweg

zu 100% ausgelastet ist und sich der eingebaute Ventilator in kurzen

Abständen geräuschvoll bemerkbar macht. Interessanterweise gibt

der Sea-Monkey-Browser im "Stillstand" fast den gesamten Speicher frei, wodurch

auch mit dem R40 parallel zum Browsen ein HTML-Editing z.B. mit dem

altbewährten

AOLPress möglich ist.

Praktisch keine Probleme zeigten sich hingegen im Packard-Bell, dessen

64-Bit-Architektur komplexere Surf-Operationen besser "wegsteckt".

Schnelles Browsen und sofortige Wiedergabe (ohne vorheriges Abspeichern)

von MP3s erlaubt (im Akoya E 1230 unter Windows 7) der Sea-Monkey-Browser

in Verbindung mit dem VLC-Player. Fast keinen RAM-Verbrauch kostet im "Total

Commander" die MP3-Wiedergabe via <F3> über den

LAV-Splitter,

während das Abspielen mit dem funktional vielseitigen, komfortablen

AIMP die 32-Bit-CPU

des Thinkpad R40 fast völlig auslastet.

|

|

2. Einen erweiterten Modus des Recherchierens und / oder Editierens bietet

das Arbeiten mit VMWare. Das Grundprogramm (der VM-Player) und die

sog. VMWare Tools sind kostenlos abrufbar. Vorausgesetzt, genügend RAM

(min. 2 GB) ist an Bord, wird unter VMWare als "virtuelle Maschine" ein zweites

Betriebssystem (vom CD-Laufwerk) installiert und eingerichtet, so z.B. (wie

meine beiden Fotos zeigen) (in einer nicht zu großen separaten Partition)

unter Windows 7 (links) auf einem virtuellen Plattenspeicher

von 15-20 GB ein Windows XP professional (rechts) mit 1 GB RAM;

hier können von externen Devices (CD/DVD-Laufwerk, USB-Stick) oder nach

Netz-Downloads die üblichen Tools und Programme installiert werden,

z.B. der Total Commander als File Manager,

/windows/system32/dfrg.msc als Defragmentierer, Sea Monkey

als Browser, Winamp lite als universeller Player und (wohl eher als

Luxus) das komplette Microsoft Office 2007. Mit einem Klick

läßt sich zwischen dem Host (Windows 7) und dem Virtuellen System

hin und her schalten. Textpassagen werden aus dem VM-System per Copy &

Paste in einen Editor des Host-Systems übernommen. Für Lautstärke

und Bildformat gelten die Host-Parameter. Eine unter VMWare abgerufene Tondatei

bleibt hörbar, wenn auf den Host umgeschaltet wird. Im exclusive

view Modus füllt der virtuelle Desktop den ganzen Bildschirm aus

(womit der Eindruck entsteht, der Computer arbeite nun tatsächlich nur

mit dem virtuellen System), <Ctrl-Alt> holt die obere Steuer-Leiste

(Statuszeile) der VM Workstation zurück.

Es lohnt sich kaum, in einfacheren Rechnern wie dem Medion Akoya E 1230 Virtuelle

Maschinen einzurichten, weil hierdurch ggf. die Systenmstartzeit verlangsamt

und (auch ohne aktivierte VMs) der RAM-Verbrauch erhöht wird. In

anspruchsvolleren Geräten wie z.B. dem mit i7-Prozessor und max. 8 GB

RAM ausgerüsteten Samsung NP-RF511 lassen sich als Virtuelle Maschinen

z.B. ein problemlos funktionierendes Ubuntu *) und sogar auch

das Apple-Betriebssystem OS X Mountain Lion einrichten und sogar

aktualisieren. Programme wie Apple's Safari laufen hier einwandfrei,

vorausgesetzt, die Partition, auf der die Virtuelle Maschine läuft,

ist "sauber" und gut gewartet.

*) Im Mai 2013 gelang es, mittels einer neuen, modifizierten wubi.exe (2.559.512

Bytes) das neue Ubuntu 13.04 sowohl im Samsung RF 511 wie im Packard-Bell

Easy Note NCL 20 zu installieren.

-

Multimedia-Operationen, vor allem die

(a) Wiedergabe hochwertiger Video-Dateien. Die kleinen

32-Bit-Rechner schaffen die meisten Clips mit dem VLC-Player, streiken

jedoch hier bei AVCHD-Clips (*.mts), sofern es nicht gelingt, sie mit dem

Windows Media Player wiederzugeben; mit dem kleinen 64-Bit-Rechner

gibt es keine Probleme. Leichte Verbesserungen zeigen sich im 32-Bit-Sektor

bei den allerneuesten EeePCs gegenüber dem älteren Medion-Modell.

Was die

(b) Verarbeitung von Audio-Dateien angeht, so habe ich mit

dem älteren Medion E 1212 in dreieinhalb Jahren nur gute Erfahrungen

gemacht und hier mit bestimmten Programmen die meisten in diesem Zeitraum

gemachten, anspruchsvollen Live-Konzertaufnahmen gemastert. Zur

Wiedergabe von Audio-Dateien aller Art (*.wav, *.mp3, *.wma u.a.)

empfehle ich die Lite-Version des über viele Jahre hinweg bewährten

und stetig verbesserten Winamp-Players.

(c) das Brennen von Audio-CDs geschieht bei den EeePCs

fast ausnahmslos über externe Laufwerke. Nach meinen Erfahrungen zeigen

sich hier Unterschiede beim Brennen von "randvollen" (also mindestens

80-minütigen) CDs (deren Spuren von innen nach außen geschrieben

werden); nicht alle Laufwerke gestatten ein "Überbrennen" (overburning).

Als Brenn-Programm dienten mir verschiedene NERO-Versionen. Während

Laufwerke von Samsung und sogar das (treiberkorrekt implementierte)

Apple-Superdrive Probleme machte, arbeitete (am Medion) ALDIs preiswertes

Medion-Laufwerk ohne Fehl und Tadel. Auch Video-DVDs ließen

sich mit dem E 1212 und seinen "Kollegen" mühelos erstellen.

-

Für das Erstellen von Texten ist nicht zwingend ein so

hochkompliziertes Paket wie Windows Office erforderlich: die Qualität

von Gedanken bessert sich nicht mit der Software. Ein einfacher Editor

genügt, es sei denn, man "layoutet" die eigene Arbeit für den Druck.

Problematischer wird es, wenn HTML-Texte zu erstellen sind; die meisten

Autor/innen kennen nur wenige "Tags" und sind besser beraten mit einem

WYSIWYG-Programm: what you see is what you get. Diesen Text schreibe ich

- unglaublicherweise - mit AOLPress, das ich seit Mitte 1996 benutze

und das sogar Frames in der Homepage und bunte Tabellen-Kästchen

ermöglicht. Das Tollste bei AOL ist jedoch, daß man die in den

eigenen Texten gesetzten Links direkt "browsen", also verifizieren kann.

Das noch unter Windows 7 einwandfrei laufende AOLPress ist also auch ein

vollwertiger Browser, wenn man von bestimmten

Sonderpräsentationsformen in neueren Homepages absieht. Werden Homepages

erstellt und soll zur Ausgestaltung der Links recherchiert werden, so geschieht

das über einen separaten schnellen Browser (z.B. Mozilla Firefox oder

Sea Monkey); die URLs der hier über Google oder die Wikipedia gefundenen

Seiten werden mit <Ctrl-C> kopiert und per

<Ctrl-V> ins HTML-Fenster des Editors übernommen (Copy

and Paste). Auf diese Weise lassen sich recht zügig größere

und mit vielen informativen Links versehene HTML-Seiten in kurzer Zeit erstellen.

Bilder (Copyright beachten!) werden als (überarbeitend

komprimierte) *.jpg eingefügt, Tondateien als

(möglichst hochwertige und dennoch ökonomisch dimensionierte)

*.mp3 (welche Qualität schon bei 96 kBps erzielbar ist, dürfte

aus den vielen Samples in meinem

oHost-Webspace

hervorgehen). Animationen und Ähnliches fallen in

geisteswissenschaftlichen Texten wohl kaum an, deshalb genügt unser

Netbook, dessen Hard- und Software für ein recherchierendes

Konzipieren ausreichen dürfte, wie ich es z.B. in den Jahren 2002-2008

im Rahmen meiner

"Deutschen

Landes- und Kulturkunde" als Informationsbasis jeder einzelnen Sitzung

vorgenommen habe.

-

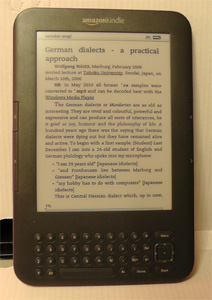

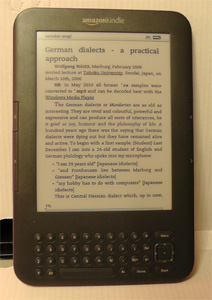

Für

das Browsen und Überprüfen von Texten (auch als handliche

Manuskript-Vorlagen in Seminaren und Vorlesungen) gibt es neuerdings

eine ebenso handliche wie nützliche Hilfe: die eBook-Reader,

die für etwa 100 bis 150 Euro angeboten werden. Sie verarbeiten verschiedene

Formate wie *.epub, *.mobi, *.azw, *.prc, *.pdf, einige auch *.htm(l). Mit

(kostenlosen) Werkzeugen wie dem Mobipocket Creator oder dem noch komplexeren

Programm Calibre lassen sich aus verschiedensten Texten eBooks erstellen,

so z.B. aus Seiten der eigenen Homepage (inclusive aller Bilder), die dann

mit den frühstücksbrettgroßen eReadern überall gelesen

werden können. Zudem ermöglicht der exklusiv von Amazon

vertriebene Kindle-Reader mit Tastatur und (kostenlosem!)

WiFi-3G-Zugang das Browsen nicht nur intern via WLAN in Wohnung,

Büro oder Hörsaal, sondern auch an beliebigen Orten und

völlig unabhängig von dort vorhandenen Netzressourcen innerhalb

der englischsprachigen Wikipedia (wobei auch weiterführende Links

zu englischsprachigen Seiten besucht werden können). Der interne Speicher

des Kindle 3G (Bild rechts) umfaßt 3 GB und kann dort u.U. mehrere

tausend Bücher unterbringen. Eine komfortable Such-Funktion erstreckt

sich auf sämtliche Dateien des internen Bestandes. Das etwas billigere

Thalia-Cybook Odyssey hat eine Touchscreen-Tastatur, auf WLAN begrenztes

WiFi und knapp 2 GB Speicher, jedoch einen Slot für Micro-SD-Karten,

so daß bis 16 oder gar 32 GB an zusätzlichen Daten gespeichert

werden können, darunter auch MP3s, die in guter Qualität über

interne Lautsprecher oder via Stereo-Klinkenbuchse an externe Anlagen

reproduziert werden. Im Kindle versteht sich die MP3-Wiedergabe lediglich

als Hintergrund-Musik während des Lesens, beim Cybook sind die MP3s

einzeln aufrufbar. Das Cybook liest auch deutschsprachige *.htm (also mit

allen Sonderzeichen des 8-Bit-Codes), während der Kindle mit seinem

englischsprachigen Menü nur 7-Bit-*.htm verarbeitet, es sei denn, die

*.htm wurden via Calibre oder Mobipocket ins eBook-Format gewandelt.

Für

das Browsen und Überprüfen von Texten (auch als handliche

Manuskript-Vorlagen in Seminaren und Vorlesungen) gibt es neuerdings

eine ebenso handliche wie nützliche Hilfe: die eBook-Reader,

die für etwa 100 bis 150 Euro angeboten werden. Sie verarbeiten verschiedene

Formate wie *.epub, *.mobi, *.azw, *.prc, *.pdf, einige auch *.htm(l). Mit

(kostenlosen) Werkzeugen wie dem Mobipocket Creator oder dem noch komplexeren

Programm Calibre lassen sich aus verschiedensten Texten eBooks erstellen,

so z.B. aus Seiten der eigenen Homepage (inclusive aller Bilder), die dann

mit den frühstücksbrettgroßen eReadern überall gelesen

werden können. Zudem ermöglicht der exklusiv von Amazon

vertriebene Kindle-Reader mit Tastatur und (kostenlosem!)

WiFi-3G-Zugang das Browsen nicht nur intern via WLAN in Wohnung,

Büro oder Hörsaal, sondern auch an beliebigen Orten und

völlig unabhängig von dort vorhandenen Netzressourcen innerhalb

der englischsprachigen Wikipedia (wobei auch weiterführende Links

zu englischsprachigen Seiten besucht werden können). Der interne Speicher

des Kindle 3G (Bild rechts) umfaßt 3 GB und kann dort u.U. mehrere

tausend Bücher unterbringen. Eine komfortable Such-Funktion erstreckt

sich auf sämtliche Dateien des internen Bestandes. Das etwas billigere

Thalia-Cybook Odyssey hat eine Touchscreen-Tastatur, auf WLAN begrenztes

WiFi und knapp 2 GB Speicher, jedoch einen Slot für Micro-SD-Karten,

so daß bis 16 oder gar 32 GB an zusätzlichen Daten gespeichert

werden können, darunter auch MP3s, die in guter Qualität über

interne Lautsprecher oder via Stereo-Klinkenbuchse an externe Anlagen

reproduziert werden. Im Kindle versteht sich die MP3-Wiedergabe lediglich

als Hintergrund-Musik während des Lesens, beim Cybook sind die MP3s

einzeln aufrufbar. Das Cybook liest auch deutschsprachige *.htm (also mit

allen Sonderzeichen des 8-Bit-Codes), während der Kindle mit seinem

englischsprachigen Menü nur 7-Bit-*.htm verarbeitet, es sei denn, die

*.htm wurden via Calibre oder Mobipocket ins eBook-Format gewandelt.

-

Verwendung

von "Alt-Geräten" ('vintage gear'). Wer sich heute mit winzigen

Bildschirm-Tastaturen (in touch screens), wackligen Keyboards oder

unergonomischen Touchpads in kleinen Net- und Notebooks (wie z.B. dem oben

erwähnten neuen Akoya E 1230) herumplagt und meint, damit den

wissenschaftlichen Olymp erobern zu können, ist selbst schuld.

Verwendung

von "Alt-Geräten" ('vintage gear'). Wer sich heute mit winzigen

Bildschirm-Tastaturen (in touch screens), wackligen Keyboards oder

unergonomischen Touchpads in kleinen Net- und Notebooks (wie z.B. dem oben

erwähnten neuen Akoya E 1230) herumplagt und meint, damit den

wissenschaftlichen Olymp erobern zu können, ist selbst schuld.

Ich tippe diese (Zwischen-)Zeilen gerade mit einem alten hp-Compaq

nx6110 (Bild rechts). Ich habe ihn, inclusive eines unten andockbaren

"Reiseakkus", Anfang März 2006 im Handgepäck nach Sendai mitgenommen

für meinen Vortrag; nicht

zu groß erschien er mir damals. Heute arbeitet er mit 1,3 GB RAM und

einer 100-GB-Festplatte; die LAN-Anbindung erfolgt im 100-MBit-Mode über

eine D-Link-PCMCIA-Karte. Mit passendem Lesegerät erkennt er auch neueste

SDHC-Karten (von denen ich soeben "geschossene" Bilder in diesen Text

einarbeitete). Ubuntu-Installationen werden von diesem etwa sieben Jahre

alten Gerät schneller ausgeführt als von manchem ultramodernen

Netbook. Ich muß gestehen, es ist ein Hochgenuß, auf den "normal"

großen, hervorragend verarbeiteten Tasten zu tippen; sie haben den

so wichtigen definierten Druckpunkt und kleine Senken wie richtige

Schreibmaschinen- oder die älteren originalen IBM-Keyboards. Wie mickrig

und unergonomisch dagegen die meist schwammigen (aber teils

trendy-hochglanzpolierten) Tastaturen der ultramodernen Notebooks und solcher

Netbooks wie dem weiter oben hochgelobten Packard-Bell Easy Note

Butterfly, dessen zwar große, aber flache Tasten mit nur schmalen

Zwischenräumen allzuleicht zu "Streif"-Fehlern führen, vor allem,

wenn man, wie ich, zwar schnell, aber nur mit zwei Fingern schreibt. Modern

und zeitgemäß arbeiten heißt nicht zwingend, mit dem

allerneuesten Equipment arbeiten, sondern, meiner Ansicht nach, das Beste

aus Vergangenheit und Gegenwart zu kombinieren, um in bester Qualität

ein Maximum zu erzielen. Gute, verständliche Texte lassen sich also

auch mit älterem, doch sehr zuverlässigem und robustem Gerät

erstellen. Unter dem auch bereits ziemlich betagten Windows XP arbeitet das

hp-Notebook vergleichsweise ausgesprochen flink und kommt eher zur Sache,

während sich unter dem in ultramodernen Gegenwarts-PCs arbeitenden Windows

Vista, 7 und 8 bisweilen Verzögerungen ergeben durch die enorm

aufgeblähten, umständlich arbeitenden Programmstrukturen und teils

wirklich unnötige Hintergrundprogramme wie Uhr, Kalender, Wetterstationen,

Animationen u.a.

Was für unser zentrales Werkzeug, den Rechner gilt, das gilt auch für

unerläßliche periphere Geräte: Drucker, Scanner etc.,

aber auch Tonaufnahme- und Wiedergabegeräte, CD-Spieler,Verstärker,

Lautsprecher usw. - vorausgesetzt, die Räumlichkeiten erlauben deren

Unterbringung und Betrieb. So hat es, wie angedeutet, überhaupt keinen

Sinn, etwa Cassettenrecorder und / oder -spieler und deren Medien zum "alten

Eisen" zu werfen, wo doch noch heute eine in puncto Medien, Recorder und

Mikrofonierung erstellte Cassetten-Tondokumentation in klanglicher Hinsicht

mithalten kann mit digitalen Alternativen; noch heute läuft in jeder

meiner Live-Aufnahmen ein TCD5M mit, dessen Tongüte in nichts der digitalen

Aufnahme nachsteht.

Wissenschaft bedeutet nicht nur, dem state-of-the-art hinterherzulaufen,

sondern vielseitig zu sein und (in Forschung und Lehre)

situationsgemäß das passende Werkzeug und die adäquate

Methodik einzusetzen und - wie ich oben sagte, dabei möglicherweise

Alt und Neu zu optimaler Synergie zu bringen.

-

Parallel-Betrieb mit mehreren PCs

Es ist natürlich äußerst attraktiv und ergonomisch, alles

"an Bord" zu haben: die Datei, die man soeben noch mit einer aufwendigen

Software bearbeitete, sofort danach auf den persönlichen Server zu laden

und wenig später mögliche Reaktionen per Email abzurufen und in

den zugehörigen wissenschaftlichen Text einzuarbeiten, der dann wiederum

gleich hochgeladen wird. Solche Kombinationslösungen sind hingegen eine

Gefahrenquelle erster Ordnung: der angesprochene Workflow ist anfällig

für Viren aller Art. Andererseits sind die Gerätepreise derart

gesunken, daß es gerade im wissenschaftlichen Bereich nicht mehr

verantwortbar ist, alle Arbeitsvorgänge mit ein und demselben Gerät

zu erledigen. Setzen wir für ein simples Netbook ca. 300 Euro an und

für ein zumindest begrenzt multimediafähiges (wie das angesprochene

Packard-Bell Easy Note) ca. 400 Euro, so hätten wir für einen

Hardware-Preis von nur rund 1000 Euro nicht weniger als drei mit jeweils

dem neuesten Betriebssystem ausgerüstete PCs, deren Verwendung wie folgt

zu skizzieren wäre:

Rechner

|

Software (nur Beispiele)

|

Viren-

Scanner |

Aufgabe(n)

|

PC 1:

Netbook

(Atom 1,6 GHz) |

mehrere Browser (Option: anonymes

Surfen), Total Commander

VLC-Player, CCleaner, Defrag |

X |

Informationsgewinnung

Google-Recherchen

Mailing (mit Attachments) |

PC 2:

Netbook

(Atom 1,6 GHz) |

Texteditor, MS-Office und / oder Open Office

Total Commander, CCleaner, Defrag

|

X |

Editing: Erstellung von Texten,

Präsentationen, Tabellenkalkulation

etc., Daten-Upload |

PC 3:

Notebook oder

Desktop (MM-fähig) |

z.B. Adobe Audition Pro (mit Plugins)

Standalone-Video-Schnittsoftware,

CCleaner, Total Commander, Defrag |

|

AV-Signal-Messungen (z.B. Phonetik),

AV-Bearbeitung (Korrekturen, Sound-

Design), Digitalisierung, Datensicherung |

PCs 1 und 2 arbeiten softwaremäßig ohne Mehrkosten

(Ausnahme: MS-Office), während PC 3 als Meß- und

Prozeßrechner u.U. kostspielige Sonderprogramme an Bord hat, ohne

Netzanbindung arbeitet und daher keinerlei (systemverlangsamenden)

Virenscanner benötigt, sofern regulär erworbene Software

benutzt und keine Fremdmaterialien verarbeitet werden. Der wissenschaftliche

Workflow wird zudem durch das parallele Arbeiten mit allen 3 PC-Systemen

enorm gesteigert. Für den Transfer/Upload von mit PC 3 erarbeiteten

Materialien werden ausschließlich frisch formatierte, softwarefreie

Datenträger (USB-Sticks, SDHCKarten, externe Festplatten) verwendet.

Das sind, in groben Zügen, einige der von uns Geisteswissenschaftlern

genutzten, PC-orientierten Arbeitsformen. Was die einzelnen Ein- und

Ausgänge der PCs angeht, so dürfte wohl Klarheit herrschen - auch

darüber, daß neuerdings auch in kleinere Note- und Netbooks

USB3-Interfaces eingebaut werden, die natürlich einen weit besseren

Daten-Durchsatz ermöglichen als ihre Vorgänger. USB 3 ist allerdings

nur wichtig für Leute, die sehr viele und große Mengen von Dateien

auf externen Festplatten sichern und die auch Programme von diesen starten

- was durchaus auch via USB 2 möglich ist, so habe ich öfter

Audio-Editing und sogar die auch in meiner Deutschen Landes- und

Kulturkunde für Ausländer didaktisch genutzte

Flugsimulation von externen

Festplatten aus betrieben. Überhaupt eignet sich der Microsoft-Flugsimulator

9, eines der komplexesten und umfangreichsten Programme, hervorragend dazu,

die Multimediafähigkeit eines PCs objektiv zu testen - von dem noch

anspruchsvolleren Nachfolger FS X ganz zu schweigen. Wer eine Szenerie wie

den Flughafen Rhein-Main ohne Bild-Ruckeln überfliegt, hat einen in

jeder Hinsicht untadeligen PC. Nur wenige auch unter den teuren tragbaren

PCs können dies leisten, für geisteswissenschaftliches Arbeiten

sind Computer-Spiele ohnehin ein Luxus und ohne Belang.

Soll der PC absolut sicher und zuverlässig arbeiten, ist auch seine

Memory-Bestückung ausschlaggebend. Nur erstklassige Bausteine

(Chips) von renommierten Herstellern dürfen "an Bord" sein, wenn nicht

ab und zu die gefürchteten "Blue Screens" das Arbeiten versauern sollen.

Wer sich traut, Memory-Chips selbst auszuwechseln, sollte zuvor den Akku-Pack

herausziehen und danach etwas warten, um den PC stromlos zu machen. Vor dem

Herausziehen der empfindlichen Bausteine (deren Kontakte keinesfalls

berührt werden dürfen) sollte man sich in irgendeiner Form "erden"

und keine Stoffe anfassen, deren Berührung eine den Chip augenblicklich

zerstörende elektrostatische Aufladung hervorrufen könnte.

Nach dem Einsetzen der neuen Memory-Streifen den Akkupack einsetzen und das

Gerät starten. Kommt der erste System-Bildschirm und gibt es keine

Warntöne, war das Upgrade erfolgreich.

Ebenso grundsätzlich wichtig sind das Betriebssystem und

arbeitsfördernde Hilfsprogramme, die sog. Tools. Viele hilfreiche

Tools werden im Internet angeboten. Wer mehrere Rechner besitzt, sollte sie

zunächst auf einem "Neben-PC" testen, um den wichtigen Hauptrechner

nicht zu gefährden. In den letzten vier Jahren machte ich eine Reihe

umfangreicher vergleichender Experimente mit Windows XP, Windows 7, Windows

8, verschiedenen Ubuntu-Versionen und, auf einem Mac Book Pro, den letzten

Versionen von Mac OS X; eine knappe Hälfte des Mac wurde per Bootcamp

für Windows Vista eingerichtet, das, ebenfalls in der "Tiny"-Version,

auch auf dem Medion Akoya gelaufen war. Zusammenfassend läßt sich

feststellen:

-

Windows XP professional ist unter allen Windows-Varianten bis heute

am effektivsten, das konnte auch in neueren Versuchen (Juli 2015) z.B. mit

einem IBM Thinkpad R40 vom Herstellungsjahr 2003 bestätigt werden. XP

startet schnell, hat ein hervorragendes Plug-and-Play und eine sehr

ökonomische Speicherverwaltung.

-

Windows Vista dagegen umständlich und langsam; ebenso wie in

Windows 7 entsteht hier ein Directory \winsxs, das nach rund 4 Monaten Betrieb

im Akoya E1230 63.809 Sub-Pfade umfaßte; das gesamte Windows

7 belegte rund 27 Gigabytes (!)

-

Windows 7 und Windows 8 erscheinen zwar eleganter und einfacher, bringen

jedoch in puncto Daten-Management kaum Vorteile; die im Frühjahr 2013

vorgestellten, neuen Windows-8-Rechner arbeiten mit UEFI-Bios und Secure

Boot und gestatten keine Ubuntu-Parallelinstallation. Das Update von Windows

8 professional auf Win 8.1 kann mehrere Stunden in Anspruich nehmen. Für

rein wissenschaftliches Arbeiten ergeben die "Kachel-Apps" keinen Sinn.

-

der Mac und sein Betriebssystem OS-X haben keine "durchsichtige"

Datenstruktur wie die Windows-Varianten (d.h. es fehlt die Möglichkeit,

einzelne Systemdateien zu suchen und ggf. zu ersetzen/aktualisieren). Es

gibt keine wirklichen Verbesserungen in puncto Textedition und -verarbeitung,

allerdings arbeitet der Mac

-

mit Bootcamp unter Windows (Tiny) Vista anscheinend effektiver

als die vergleichsweisen Microsoft-basierten Rechner.

-

Die (bis 2016 verwendeten) Versionen (9.04 - 12.04) und Varianten

des Linux-Derivats Ubuntu ließen sich auf vielen Rechnern problemlos

installieren und ermöglichen z.B. auf dem rund acht Jahre alten DELL

Inspiron 9100 eine Bildschirmdarstellung in Full-HD-Format. Alle

Partitionen des Rechners können schnellstens "eingehängt" und damit

voll verwaltet werden. Bisher ermittelte Ausnahmen: Medion Akoya E1230 mit

1024x600 Pixeln und Packard-Bell NCL20 mit Celeron

SU23001). Unter dem stetig verbesserte Wine-Layer

laufen viele Windows-Programme, so auch der o.a. Total Commander,

der Einblick in die komplette Linux-Datenstruktur und sogar das Kopieren

und Moven von Daten zwischen Linux und Windows ermöglicht,

oder das sehr umfangreiche Microsoft Office 2007 (mit allen Teilen).

Das Programm Simple Scan bindet installationslos Geräte wie den

USB-gespeisten Canon LIDE ein und liefert brauchbare Dokument-Kopien.

Die Texterstellung mit Open Office bietet etwa dieselben Ressourcen

und Funktionen wie die entsprechenden Microsoft-basierten Programme. Nicht

alle Drucker lassen sich einbinden.

(Ergänzungen vorbehalten)

Unerläßlich ist als "Daten-Hygiene" ein in kürzesten

Abständen vorgenommenes Defragmentieren aller Partitionen bzw.

Logischen Laufwerke - am besten jeden Tag und / oder nach dem Installieren

zusätzlicher Software. Zuvor sind alle temporären und sonstwie

unnützen Dateien zu löschen. Dafür gibt es ein ebenfalls

kostenloses Tool: den CCleaner; der entfernt auch Cookies und andere

Browser-Spuren, die dem Benutzer zum Nachteil werden können. Vom

Defragmentieren der USB-Sticks und SD-Karten wird allerdings

abgeraten; durch diesen aufwendigen, an die Substanz gehenden Prozeß

könnten sie zerstört werden. Dasselbe gilt für

Solid-State-Festplatten

(SSDs), die in jüngster Zeit immer zuverlässiger und

preisgünstiger geworden sind.

Wer sich traut, kann viele auf 32-Bit-Basis operierende Programme

(*.exe) und Bibliotheken (*.dll) mit UPX packen und so

auf den Laufwerken viel Platz gewinnen. Daß UPX-gepackte Programme

langsamer starten, ist mir noch nie nachteilig aufgefallen. Wer dennoch die

"Originale" zurückhaben will, kann das mit <UPX -d (Datei)> erreichen.

Bekanntlich lassen sich unter Windows alle Laufwerke auch

komprimieren, wobei geeignete Dateien ähnlich wie mit UPX (oder

als *.-zip) behandelt und bei Gebrauch entpackt werden. Wird dieser Prozeß

auf einem Laufwerk mit sehr vielen Dateien angewandt, kann das u.U. einen

Tag lang dauern, auf jeden Fall sollte dann das komprimierte Laufwerk

defragmentiert werden, wobei der Nutzer sein blaues Wunder erlebt, denn die

ganze Datenstruktur ist total durcheinandergeraten und es gibt viele rote

(d.h. total fragmentierte) Zonen. Daher empfiehlt es sich, gleich zu Anfang

eine leere Partition mit oder ohne die Option "Komprimierung" zu formatieren.

Keinesfalls jedoch das aktive Start-Laufwerk (mit dem Betriebssystem)

komprimieren, danach kann es passieren, daß der Rechner nicht mehr

bootet.

Die Arbeitsgeschwindigkeit besonders kleinerer Rechner hängt auch davon

ab, ob ein - und welcher - Virenscanner im Hintergrund mitläuft:

heute, und besonders unter Windows, ein Muß, gibt es doch mittlerweile

hunderttausende von teils höchst aggressiven Viren, die, als sog. Root-Kits,

sogar die unterste Ebene des Betriebssysstems so schädigen können,

daß der Rechner ganz oder teilweise unbrauchbar und ein Tausch der

Festplatte nötig wird. Ich habe mit dem ebenfalls kostenlosen

Avira gute Erfahrungen sammeln können. Man sollte allerdings

bedenken, daß (sofern Internetverbindung vorliegt) dieses Programm

jeden Tag die Konstellation des Computers prüft und Updates

hinzuinstalliert, was bei einigen parallel laufenden Prozessen (zum Beispiel

dem Brennen von CDs / DVDs) stören kann. Deshalb sollte bei wichtigen

Dateisicherungen oder Brenn-Prozessen der PC vom Daten-Netz getrennt

werden, wozu der LAN-Stecker gezogen oder das interne WLAN-Modul deaktiviert

werden muß. Man muß ja nicht ständig am Internet hängen

und kann immer dann offline arbeiten, wenn keine Informationen von

außen benötigt bzw. nichts nach außen transportiert werden

soll. Dann können wenigstens auch keine Viren in den PC gelangen, wovor

man grundsätzlich nicht 100%ig sicher ist.

Wird der Rechner nur oder überwiegend für nicht-internetgebundene

Aktivitäten genutzt, sollte das Automatische Update deaktiviert

werden - es nervt ungeheuer, wenn man nicht zu kontinuierlichem Arbeiten

kommt oder gar eine wichtige Präsentation dadurch gestört wird,

daß wegen irgendwelcher kürzlich im Hintergrund geladener, als

wichtig deklarierter Updates der Rechner zum Abschalten und Wiederstarten

gezwungen und zu langwieriger, oft stundenlanger Installation der Updates

herangezogen wird.

Beobachten Sie öfter die Festplatten-Kontroll-LED. Flackert sie, auch

wenn nichts geladen oder abgespeichert wird, ist dies ein Zeichen für

im Hintergrund laufende Prozesse (mit denen möglicherweise Ihr Rechner

ausgespäht wird!). Mit <Ctrl-Alt-Del> gelangen Sie in den Task

Manager, der Sie darüber informiert. Es sollten möglichst alle

- oft als "Wunderheiler" offerierten Hintergrund-Kontrollprogramme

(z.B. Geek Buddy) deaktiviert werden - es sei denn, Sie legen Wert auf einen

langen Systemstart und hohen RAM-Verbrauch. Sind Sie nicht sicher, was da

alles an TSRs mitläuft, gehen Sie, z.B. mit einer (weniger aufwendigen,

also nicht zu neuen) TuneUp-Version in den Startup Manager und

deaktivieren bzw. löschen Sie dort alle Programme, die nicht zwingend

zum Betriebssystem und (etwa als Treiber) den PC-Komponenten

gehören.

Wichtig beim Arbeiten mit vor allem kleineren PCs ist deren

Kühlung - vor allem wenn sehr rechenintensive Programme "gefahren"

werden und / oder der PC den ganzen Tag (und / oder die Nacht) hindurch

läuft. Nicht alle Notebooks haben hierzu genügend Abstand von der

Tisch-Oberfläche, weswegen sich empfiehlt, mit zusätzlichen Gummi-

oder Filzfüßen den Abstand zu vergrößern. Es gibt aber

auch Software wie CPUIdle, die in Arbeitspausen den Prozessor so gut

wie möglich herunterfährt. Auch hilft es, unnötige, beim

Computerstart aktivierte Hintergrundprogramme (wie Kalender, Audioplayer

etc.) zu deaktivieren, was auch das Booten beschleunigen kann. Die

Energie(spar)-Optionen lassen sich ohnehin in der sog. Systemsteuerung

individuell einstellen. Doch: Vorsicht bei zu sparsamen Optionen, so kann

ein zu schnelles, vorzeitiges Abschalten der Festplatte wichtige

Langzeitspeicher-Vorgänge sabotieren!

Grundsätzlich gilt: ein kleines Note- oder Netbook ist kein

Dauer-Rechner.

Datengewinnung aus Fotos und Filmen

In meinen Anfangsjahren am "Deutschen Sprachatlas" hatten wir ein richtiges

Fotolabor mit chemischer Entwicklung und sogar einem Repro-Tisch. Mit einer

edlen Leica wurde auf Ilford-PAN F fotografiert, einem der damals besten

Schwarzweiß-Negativfilme. Natürlich wurden in den frühen

70er Jahren des vergangenen Jahrhunderts mit sogenannten Umkehr-Filmen

auch viele Farbdias gemacht und so wissenschaftlich relevante Exkursionen

(wie die im August 1973 in die Südschweiz und nach Oberitalien)

dokumentarisch festgehalten, weshalb wir auf diese Weise noch heute z.B.

Porträts von Dialektsprechern aus dem walserdeutschen Gebiet

besitzen (hier meine mit dem Grundig

TK 3200 gemachten Tonaufnahmen dazu).

Gefilmt wurde nicht, das wäre zu aufwendig gewesen, obwohl es mit

amateurmäßigen Movie-Kameras und Magnet-Tonspur möglich gewesen

wäre. Es gibt ja bereits seit langem Überlegungen dahingehend,

zum Beispiel einen Dialektsprecher während seiner Äußerung

zu filmen und synchron die Mundbewegungen seiner Sprachproduktion festzuhalten

(Röntgenfilme von Sprechakten gab es schon im frühen 20.

Jhd.). Doch hätte es damals, wie bei Tonaufnahmen, noch keine

Möglichkeiten gegeben, solche Kurzfilme zu digitalisieren und entsprechend

auszuwerten.

Erst um die Jahrtausendwende nahm die Digitalisierung auch Einzug in die

Foto- und Filmwelt. Die ersten Digitalkameras hatten weniger

als 1 Megapixel an Auflösung und galten eher als Spielzeug denn als

Alternative zu den höchst feinkörnigen Schwarzweiß- und

Farbfilmen. Das galt auch für die ersten digitalen Moviekameras. Im

Herbst 2002 machte ich (auf privater Basis) mit einer preiswerten hp photosmart

318 meine ersten Versuche in digitaler

Fotografie und filmte zum ersten Mal fünfeinhalb Jahre

später mit einer gebrauchten Mini-DV-Moviekamera Panasonic NV-DS 29

(auch um einen der Kurzfilme am 15.4.2008 in meiner

"Deutschen Landes- und

Kulturkunde für ausländische Studierende" zu präsentieren).

Inzwischen sind das analoge Fotografieren und Filmen völlig in den

Hintergrund geraten; preiswerte Mini-Digitalkameras mit bis zu 16 Megapixel

und der Fähigkeit zum Filmen in High Definition sind bereits

ab 100 bis 150 Euro erhältlich. Die nur ca. 9,3 x 5,3 x 1,8 cm messende

und 152 g schwere Panasonic Lumix

DMC-FS18 mit Leica-Objektiv

(rechts) fotografiert mit 16 Megapixel

und filmt in HD (720p). Die etwas größere, mit GPS und 20x optischem

Zoom bestückte, voll explorationstaugliche "Reise-Kamera" Lumix

DMC-TZ31 ermöglicht echte

AVCHD-Videos (1080p) mit Stereo-Ton (Foto-Beispiele

in meiner

Facebook-Seite);

die nur unwesentlich

größere DMC-TZ61 bietet sogar 30-fachen optischen Zoom

und hat über dem LCD-Display sogar einen kleinen, an das Auge

anpaßbaren elektronischen Sucher. Die als Nachfolgerin

der

HDC-TM99 für rund 450 Euro angebotene, etwa 12 x

6,5 x 5,2 cm große und (incl. Akku) nur 311 Gramm wiegende Panasonic

HC-V 707 mit bis 46x ptischem Zoom fotografiert mit 6,1

Megapixel und filmt in HD (AVCHD, max. 1080i) und professionell anmutendem

Stereo-Ton (Beispiele hierzu in meinem YouTube-Kanal

wnaesermr). Zudem hat sie (wie ihre oben erwähnte Vorgängerin)

einen Anschluß für externe Mikrofone und eignet sich auch

damit bestens für anspruchsvolle audiovisuelle Feldforschung.

(rechts) fotografiert mit 16 Megapixel

und filmt in HD (720p). Die etwas größere, mit GPS und 20x optischem

Zoom bestückte, voll explorationstaugliche "Reise-Kamera" Lumix

DMC-TZ31 ermöglicht echte

AVCHD-Videos (1080p) mit Stereo-Ton (Foto-Beispiele

in meiner

Facebook-Seite);

die nur unwesentlich

größere DMC-TZ61 bietet sogar 30-fachen optischen Zoom

und hat über dem LCD-Display sogar einen kleinen, an das Auge

anpaßbaren elektronischen Sucher. Die als Nachfolgerin

der

HDC-TM99 für rund 450 Euro angebotene, etwa 12 x

6,5 x 5,2 cm große und (incl. Akku) nur 311 Gramm wiegende Panasonic

HC-V 707 mit bis 46x ptischem Zoom fotografiert mit 6,1

Megapixel und filmt in HD (AVCHD, max. 1080i) und professionell anmutendem

Stereo-Ton (Beispiele hierzu in meinem YouTube-Kanal

wnaesermr). Zudem hat sie (wie ihre oben erwähnte Vorgängerin)

einen Anschluß für externe Mikrofone und eignet sich auch

damit bestens für anspruchsvolle audiovisuelle Feldforschung.

Als Datenträger dienen die kleinen SD- bzw. SDHC-Karten mit

Kapazitäten bis 32 (oder SDXC = 64) Gigabytes. Das bedeutet nichts anderes

als daß heute auch mit kleinem Budget hochwertige Fotos und Filme erstellt,

diese in den Computer eingelesen, dort beliebig weiterverarbeitet und

schließlich auch wissenschaftlich verwendet werden

können. Das weite Anwendungsspektum solcher kombinierter Foto- und

Moviekameras gestattet nun, z.B. in kleiner Auflösung Dialekte oder

andere relevante Aussagen audiovisuell zu dokumentieren und didaktisch

zu präsentieren; so wirkt ein Mundartsprecher in seiner heimischen Umwelt

viel authentischer und daher überzeugender als lediglich in einer

Tonaufnahme. Außerdem gestattet die mit solchen kompakten Kameras ebenfalls

mögliche Serienbild-Aufnahme, die Gestik und Mimik von Sprecher/innen

in kleinsten Schritten zu dokumentieren. Das oben erwähnte kompakte

Notebook

Packard-Bell Easy Note Butterfly XS von 2012 und seine

in den folgenden Jahren vorgestellten, teils noch preiswerteren Konkurrenten

sind in der Lage, alle diese Foto- und Filmformate zu verarbeiten.

So weit nur einige Andeutungen, aus denen schon jetzt hervorgehen dürfte,

daß mit Digitalisierung und Miniaturisierung bei

gleichzeitiger eklatanter Leistungs-Steigerung auch den angewandten

Geisteswissenschaften ganz neue, revolutionäre Arbeitstechniken zur

Verfügung stehen und daß zu deren Realisierung auch kleinere Budgets

ausreichen.

(wird fortgesetzt; begonnen: 3.8.2012, Stand: 23.7.2015)

Alle Fotos (c) W. Näser

(c) Dr. Wolfgang Näser, Marburg

Disclaimer: Bezüglich der erwähnten technischen Angaben

und Ratschläge wird jede Haftung ausgeschlossen.

cm/sec. und Vollspur gefertigten

Tonbänder wurden in großen Schränken und exakt klimatisierten

Räumen gelagert, was trotzdem gewisse Langzeitschäden wie

Schichtverklebung (bzw. -Ablösung) und / oder

unerwünschte Echos nicht ausschloß. Semiprofessionell

verwendete man im Außendienst das Uher Report oder das bei 19

cm/s rundfunktaugliche Grundig TK 3200 HiFi. Im

Cassettenrecorder-Bereich brillierte das auch im

Rundfunk-Außendienst verwendete Sony TCD-5M (links), das mit

guten Chromdioxyd- und vor allem mit Reineisenbandcassetten locker die HiFi-Norm

erfüllt. Bei mir arbeitet mein erstes TCD5M nun seit gut 27 Jahren ohne

Probleme und eignet sich noch heute ausgezeichnet als Analog-Recorder für

hochwertige Live-Konzertaufnahmen und / oder für explorative

Sprachdokumentation. Leider gibt es im Handel keine hochwertigen

Audio-Kompaktcassetten mehr.

cm/sec. und Vollspur gefertigten

Tonbänder wurden in großen Schränken und exakt klimatisierten

Räumen gelagert, was trotzdem gewisse Langzeitschäden wie

Schichtverklebung (bzw. -Ablösung) und / oder

unerwünschte Echos nicht ausschloß. Semiprofessionell

verwendete man im Außendienst das Uher Report oder das bei 19

cm/s rundfunktaugliche Grundig TK 3200 HiFi. Im

Cassettenrecorder-Bereich brillierte das auch im

Rundfunk-Außendienst verwendete Sony TCD-5M (links), das mit

guten Chromdioxyd- und vor allem mit Reineisenbandcassetten locker die HiFi-Norm

erfüllt. Bei mir arbeitet mein erstes TCD5M nun seit gut 27 Jahren ohne

Probleme und eignet sich noch heute ausgezeichnet als Analog-Recorder für

hochwertige Live-Konzertaufnahmen und / oder für explorative

Sprachdokumentation. Leider gibt es im Handel keine hochwertigen

Audio-Kompaktcassetten mehr. Es geht aber noch kleiner. Wir kommen

zu den Mini-Recordern, die - teils auf internen Speicher, teils auf

externe SD-Karten aufnehmen. So z.B. der nur 11,5 x 3,5 x 1,5cm messende

Olympus DS-40 (links)

Es geht aber noch kleiner. Wir kommen

zu den Mini-Recordern, die - teils auf internen Speicher, teils auf

externe SD-Karten aufnehmen. So z.B. der nur 11,5 x 3,5 x 1,5cm messende

Olympus DS-40 (links)  mit seinem abnehmbaren

Stereo-Kondensatormikrofon, der ausgezeichnete Sprachaufnahmen ermöglicht,

dann der vom gleichen Hersteller gefertigte, nur 11,3 x 4,5 x 1,1 cm messende

"Digital Voice Recorder" DM-3 (rechts), der sogar HiFi-gerechte Stereo-Aufnahmen

in CD-Qualität (als *.wav) liefert, dann der ebenfalls semiprofessionelle,

doch sogar von manchen Musiker-Ensembles zu Dokumentationszwecken verwandte,

11x 6 x 3,2cm große Zoom-H2, der mit seinen eingebauten Mikrofonen

sogar echtes 2- oder 4-Kanal-Surround realisiert , auf SD-Karten bis

8 GB oder mehr in vielen MP3-Raten und in *.wav aufnimmt und ausgezeichnete

Limiter und Aufnahme-Klangbearbeitungswerkzeuge "an Bord" hat. Was das kleine,

weniger als 200 Euro "teure" Gerät vermag, dürften meine Aufnahmen

des

mit seinem abnehmbaren

Stereo-Kondensatormikrofon, der ausgezeichnete Sprachaufnahmen ermöglicht,

dann der vom gleichen Hersteller gefertigte, nur 11,3 x 4,5 x 1,1 cm messende

"Digital Voice Recorder" DM-3 (rechts), der sogar HiFi-gerechte Stereo-Aufnahmen

in CD-Qualität (als *.wav) liefert, dann der ebenfalls semiprofessionelle,

doch sogar von manchen Musiker-Ensembles zu Dokumentationszwecken verwandte,

11x 6 x 3,2cm große Zoom-H2, der mit seinen eingebauten Mikrofonen

sogar echtes 2- oder 4-Kanal-Surround realisiert , auf SD-Karten bis

8 GB oder mehr in vielen MP3-Raten und in *.wav aufnimmt und ausgezeichnete

Limiter und Aufnahme-Klangbearbeitungswerkzeuge "an Bord" hat. Was das kleine,

weniger als 200 Euro "teure" Gerät vermag, dürften meine Aufnahmen

des

portablen

Medion-DVD-Players MD82767 nach längerer Standzeit. Der Display-Rahmen

läßt sich mit einem scharfen Messer auseinanderteilen; die in

China von

portablen

Medion-DVD-Players MD82767 nach längerer Standzeit. Der Display-Rahmen

läßt sich mit einem scharfen Messer auseinanderteilen; die in

China von

Für

das Browsen und Überprüfen von Texten (auch als handliche

Manuskript-Vorlagen in Seminaren und Vorlesungen) gibt es neuerdings

eine ebenso handliche wie nützliche Hilfe: die eBook-Reader,

die für etwa 100 bis 150 Euro angeboten werden. Sie verarbeiten verschiedene

Formate wie *.epub, *.mobi, *.azw, *.prc, *.pdf, einige auch *.htm(l). Mit

(kostenlosen) Werkzeugen wie dem Mobipocket Creator oder dem noch komplexeren

Programm Calibre lassen sich aus verschiedensten Texten eBooks erstellen,

so z.B. aus Seiten der eigenen Homepage (inclusive aller Bilder), die dann

mit den frühstücksbrettgroßen eReadern überall gelesen

werden können. Zudem ermöglicht der exklusiv von Amazon

vertriebene Kindle-Reader mit Tastatur und (kostenlosem!)

WiFi-3G-Zugang das Browsen nicht nur intern via WLAN in Wohnung,

Büro oder Hörsaal, sondern auch an beliebigen Orten und

völlig unabhängig von dort vorhandenen Netzressourcen innerhalb

der englischsprachigen Wikipedia (wobei auch weiterführende Links

zu englischsprachigen Seiten besucht werden können). Der interne Speicher

des Kindle 3G (Bild rechts) umfaßt 3 GB und kann dort u.U. mehrere

tausend Bücher unterbringen. Eine komfortable Such-Funktion erstreckt

sich auf sämtliche Dateien des internen Bestandes. Das etwas billigere

Thalia-Cybook Odyssey hat eine Touchscreen-Tastatur, auf WLAN begrenztes

WiFi und knapp 2 GB Speicher, jedoch einen Slot für Micro-SD-Karten,

so daß bis 16 oder gar 32 GB an zusätzlichen Daten gespeichert

werden können, darunter auch MP3s, die in guter Qualität über

interne Lautsprecher oder via Stereo-Klinkenbuchse an externe Anlagen

reproduziert werden. Im Kindle versteht sich die MP3-Wiedergabe lediglich

als Hintergrund-Musik während des Lesens, beim Cybook sind die MP3s

einzeln aufrufbar. Das Cybook liest auch deutschsprachige *.htm (also mit

allen Sonderzeichen des 8-Bit-Codes), während der Kindle mit seinem

englischsprachigen Menü nur 7-Bit-*.htm verarbeitet, es sei denn, die

*.htm wurden via Calibre oder Mobipocket ins eBook-Format gewandelt.

Für

das Browsen und Überprüfen von Texten (auch als handliche

Manuskript-Vorlagen in Seminaren und Vorlesungen) gibt es neuerdings

eine ebenso handliche wie nützliche Hilfe: die eBook-Reader,

die für etwa 100 bis 150 Euro angeboten werden. Sie verarbeiten verschiedene

Formate wie *.epub, *.mobi, *.azw, *.prc, *.pdf, einige auch *.htm(l). Mit

(kostenlosen) Werkzeugen wie dem Mobipocket Creator oder dem noch komplexeren

Programm Calibre lassen sich aus verschiedensten Texten eBooks erstellen,

so z.B. aus Seiten der eigenen Homepage (inclusive aller Bilder), die dann

mit den frühstücksbrettgroßen eReadern überall gelesen

werden können. Zudem ermöglicht der exklusiv von Amazon

vertriebene Kindle-Reader mit Tastatur und (kostenlosem!)

WiFi-3G-Zugang das Browsen nicht nur intern via WLAN in Wohnung,

Büro oder Hörsaal, sondern auch an beliebigen Orten und

völlig unabhängig von dort vorhandenen Netzressourcen innerhalb

der englischsprachigen Wikipedia (wobei auch weiterführende Links

zu englischsprachigen Seiten besucht werden können). Der interne Speicher

des Kindle 3G (Bild rechts) umfaßt 3 GB und kann dort u.U. mehrere

tausend Bücher unterbringen. Eine komfortable Such-Funktion erstreckt

sich auf sämtliche Dateien des internen Bestandes. Das etwas billigere

Thalia-Cybook Odyssey hat eine Touchscreen-Tastatur, auf WLAN begrenztes

WiFi und knapp 2 GB Speicher, jedoch einen Slot für Micro-SD-Karten,

so daß bis 16 oder gar 32 GB an zusätzlichen Daten gespeichert

werden können, darunter auch MP3s, die in guter Qualität über

interne Lautsprecher oder via Stereo-Klinkenbuchse an externe Anlagen

reproduziert werden. Im Kindle versteht sich die MP3-Wiedergabe lediglich

als Hintergrund-Musik während des Lesens, beim Cybook sind die MP3s

einzeln aufrufbar. Das Cybook liest auch deutschsprachige *.htm (also mit

allen Sonderzeichen des 8-Bit-Codes), während der Kindle mit seinem

englischsprachigen Menü nur 7-Bit-*.htm verarbeitet, es sei denn, die

*.htm wurden via Calibre oder Mobipocket ins eBook-Format gewandelt.

Verwendung